Netflix是如何做決策的?(二):什么是 A/B 測試?

神譯局是36氪旗下編譯團隊,關注科技、商業、職場、生活等領域,重點介紹國外的新技術、新觀點、新風向。

編者按:決策是行動的指南。不管是個人還是企業,每天都要面臨著無數的決策。決策的好壞會對結果產生巨大影響,如何做好決策是每個人都要上的一門必修課。在Netflix這里,他們采用了一種以實驗為導向的決策流程,先小范圍地對不同方案進行測試,根據對比效果調整,從而摸索出普遍適用的決策。他們為此還在官方技術博客推出了關于Netflix如何用A/N測試做出決策的系列文章。本文是系列文章的第二篇。后續文章還將介紹支持 A/B 測試的統計數據、實驗在 Netflix 中的作用、Netflix對基礎設施的投資是如何為實驗提供支撐和擴展的,以及 Netflix內部實驗文化的重要性。

劃重點:

A/B 測試是簡單的受控實驗

A/B測試僅改變受測項,其他一切都保持不變

一切都要從想法開始

Netflix 是如何做決策的?(一):介紹

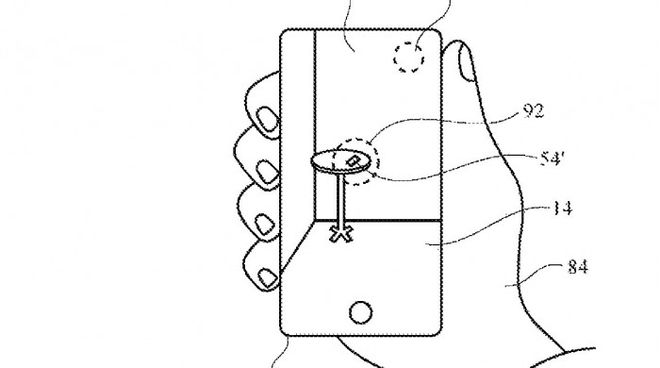

A/B 測試其實就是一個簡單的受控實驗。比方說,我們做出了一個假設!— 我們想知道一種把 TV UI 里面所有的盒子都倒置起來的新產品體驗對我們的會員是不是有好處。

圖 1:我們是怎么確定產品體驗 B(倒置的的盒子藝術)對我們的會員來說是不是會體驗更好

為了進行這個實驗,我們會取出會員的一個子集,這通常是一個從所有會員中隨機提取的簡單樣本,然后采用隨機方式將將該樣本平均分配成兩組。“A”組(通常叫做“控制組”)看到的仍然是基本的 Netflix UI 體驗,而“B”組(通常稱為“治療組”)會給予改進該會員的特定體驗的假設獲得不同的體驗(后面還會談到具體的假設)。在本例中,B 組收到的是倒置的盒子藝術。

接下來我們就是等,然后把 A 組中的各種指標跟 B 組中的各種指標進行對比。部分指標會跟特定假設相關。對于 UI 實驗來說,我們會研究跟新功能的各種變體的互動情況。對于旨在在搜索體驗當中提供更相關結果的實驗,我們會衡量會員是不是通過搜索找到了更多的可觀看內容。在其他類型的實驗里,我們可能會關注更加技術性的指標,比方說應用加載所需的時間,或者我們在不同網絡條件下所能夠提供的視頻質量情況。

圖 2:一個簡單的 A/B 測試。我們利用隨機分配將 Netflix 會員的隨機樣本分為兩組。“A”組收到的是當前的產品體驗,而“B”組收到的是我們認為會改進Netflix 體驗的變化。在本例中,“B”組收到了“倒置”的產品體驗。然后我們再對比兩組之間的指標。至關重要的是,隨機分配確保了就平均而言,兩組之間的其他一切都保持不變。

通過包括倒置的盒子藝術這個例子在內的眾多實驗,我們需要仔細思考指標告訴了我們什么。假設我們審視的是點擊率,這個指標衡量的是每一種體驗下點擊了一部作品的會員占比。光靠這個指標本身來衡量新 UI 是否成功可能會造成誤導,因為會員可能只是為了看作品更輕松點(讓倒置的變成正常)而點擊了它。在這種情況下,我們可能還希望評估一下有多少會員隨后就離開此作品了而不是繼續播放的。

在所有情況下,我們還會考察更綜合的指標,希望能夠捕捉到 Netflix 為我們的會員提供的快樂和滿足感。這些指標包括會員與 Netflix 互動程度的衡量標準:我們正在測試的想法是不是有助于我們的會員在任何特定的晚上把 Netflix 當作自己的娛樂目的地?

這其中還涉及到很多的統計數據——差異大到什么程度才可看作顯著?測試需要多少會員才能檢測出給定量級的影響?怎么才能最有效地分析數據?我們會在后續文章里面介紹其中的一些細節,重點會放在高級直覺上。

讓其他一切保持不變

因為我們是用隨機分配的放肆創建的對照組(“A”)和治療組(“B”)的,所以我們可以確保平均而言,兩組中的個體在可能對測試有意義的所有維度上都是均衡的。比方說,隨機分配可確保 Netflix 會員的平均租期在對照組和治療組之間沒有顯著差異,在內容偏好、主要語言選擇等方面也沒有顯著差異。兩組之間唯一剩下的區別就是我們正在測試的新體驗,確保我們對新體驗影響的評估不會存在任何偏見。

為了理解這一點的重要性,我們不妨思考另一種做出決定的方式:我們可以向所有的Netflix 會員推出新的倒置盒子藝術體驗(如上所述),看看我們其中的一個指標是不是會發生重大變化。如果出現了好的變化,或者沒有出現任何有意義的變化的證據,我們將保留新的體驗;如果出現不好變化的證據,我們就回滾到之前的產品體驗。

假設我們這么做了(再次地——這是個假設!),并且在當月的第 16 天切換到倒置體驗。如果我們收集到以下數據的話,你會怎么做?

圖 3:第 16 天發布的全新倒置盒子藝術產品體驗的假設數據。

數據看起來挺不錯:我們發布了新的產品體驗,會員的參與度大為提高!但是,如果你有了這些數據,再加上產品 B 將 UI 里面所有的盒子藝術倒置過來的知識的話,你對新產品體驗是不是真的對我們的會員有好處這一點又有多大信心呢?

我們是真的知道新產品體驗是導致會員參與度提高的原因嗎?還存在哪些可能的解釋?

如果你還了解到, Netflix 在(假設的)推出全新倒置產品體驗的同一天還發布了一部熱門作品,比如新一季的《怪奇物語》(Stranger Things)或《布里杰頓》(Bridgerton),或者像《活死人軍團》(Army of the Dead)這樣的熱門電影的話,又該怎么說? ? 現在我們對會員參與度提高可能就有不止一種解釋了:也許是因為新產品體驗,也許是因為社交媒體上對熱門作品的討論,也可能兩者兼而有之。或者可能完全是別的東西。關鍵是我們不知道新產品體驗是不是導致了參與度的提高。

反過來,如果我們對倒置盒子藝術產品體驗進行 A/B 測試,讓一組會員接收當前的產品體驗(“A”),另一組會員這一整月收到的都是倒置產品體驗(“B”)的話,又會怎樣?以下是收集到的數據:

圖 4:新產品體驗 A/B 測試的假設數據。

在這種情況下,我們得出了一個不一樣的結論:倒置產品導致參與度普遍較低(這并不奇怪!),而且隨著熱門作品的發布,兩個群體的參與度都增加了。

A/B 測試讓我們可以做出因果陳述。我們僅向 B 組引入了倒置產品體驗,并且由于我們是把會員隨機分配到 A 組和 B 組的,因此兩組之間的其他一切都保持不變。所以,我們可以得出倒置產品很可能導致參與度降低的結論(下一次再詳細介紹)。

這個假設的例子很極端,但一條普遍適用的經驗是總有些事情是我們無法控制的。如果我們針對所有人推出一種體驗,并在改變前后簡單地衡量一個指標的話,那么這兩個時間段之間可能存在的相關差異就會阻止我們得出因果結論。也許出現了一個正在變火的新作品。又或者是新的產品合作解鎖了更多的用戶。總會有一些我們不知道的事情。在可能的情況下,進行 A/B 測試可讓我們證實因果關系,并自信地對產品進行變更,因為我們知道,我們的會員會用自己的行為對改變進行投票。

一切從一個想法開始

A/B 測試從一個想法開始——我們可以對 UI進行修改、幫助會員查找內容的個性化系統、針對新會員的注冊流程,或我們認為會對會員產生積極影響的Netflix 體驗的任何其他部分。我們測試的某些想法是漸進式的創新,比方說改進Netflix 產品中出現的文案的手段;有些更為雄心勃勃一些,比方說讓Netflix最終在用戶界面中呈現“十大排行版”的測試。

跟面向全球 Netflix 會員推出的所有創新一樣,Top 10 一開始只是一個想法,后來變成了可檢驗的假設。此處的核心思想是將每個國家/地區流行的作品呈現出來可在兩個方面令我們的會員受益。首先,通過呈現流行內容,我們可以幫助會員分享體驗并通過對相關流行作品的討論而建立相互的聯系。其次,我們可以通過滿足人類成為共同對話的一部分內在愿望,幫助會員選擇出一些精彩的內容來觀看。

圖 5:Web UI 上的Top 10 體驗示例。

接下來,我們就把這個想法變成一個可檢驗的假設,也就是“如果我們進行 X 變更,它將會以某種方式改善成員體驗,從而令指標 Y 得到改善”。在Top 10 這個例子當中,我們的假設如下:“向會員展示Top10 體驗將幫助他們找到值得觀看的內容,增加會員的快樂和滿意度。” 這一測試(以及眾多其他測試)的主要決策指標是衡量會員跟 Netflix 的互動度:我們正在測試的想法是不是有助于我們的會員在任何特定晚上選擇 Netflix 作為自己的娛樂目的地?我們的研究表明,從長遠來看,該指標(細節此處不談)與會員保留訂閱的可能性是相關的。我們對其他業務領域,比方說注冊頁面體驗或服務器端的基礎設施等的測試,采用的是不同的主要決策指標,但原則是一樣的:就是要看我們在測試期間可以測量的東西哪些從長期來看能為我們的會員提供更多價值。

除了測試的主要決策指標以外,我們還考慮了很多次要指標,還要看這些會如何受到我們正在測試的產品功能的影響。這里的目標是把從用戶行為如何響應新產品體驗到我們主要決策指標的變化的整條因果鏈表述清楚。

闡明產品變更與主要決策指標變化之間的因果鏈,并監控這一鏈條上的次要指標,可以幫助我們建立信心,讓我們確信主要指標的任何變動都是我們假設的因果鏈的結果,而不是新功能的某些意外后果的結果(或誤報——在后面的系列文章里面我們會詳細介紹!)。對于Top 10 的A/B測試來說,參與度是我們的主要決策指標——但我們也會檢查其他一些指標,比如Top 10排名當中出現的那些作品的作品級瀏覽,也就是源自那一行而不是UI的其他部分的瀏覽量占比等等。如果符合假設的話,提供Top 10的體驗應該對我們的會員是有好處的,預期治療組中出現在Top 10的作品的瀏覽量應該會增加,而且往往是因為那一行的參與度普遍較高。

最后,因為并不是我們測試的所有想法都會成為贏家,贏得會員青睞(有時新功能會有bug!)我們還會檢查充當“護欄”的指標。我們的目標是限制任何的負面后果,并確保新產品體驗不會對會員體驗產生意外影響。比方說,我們可能會將服務對照組和治療組的客戶服務聯系人進行對比比,看看新功能是否沒有增加聯系率,因為練習率的增加可能表明會員感到困惑或不滿。

總結

這篇文章的重點是建立直覺:A/B 測試的基礎知識,為什么要跑 A/B 測試,而不是推出功能然后對比變更前后的指標,以及我們如何將想法變成可檢驗的假設。接下來,我們將介紹用來對比治療組與控制組體驗指標的的基本統計概念。

譯者:boxi。